Sexta, 19 de Abril de 2024

Após noiva morrer, homem conversa com ela durante meses

26/07/2021 as 20:19 | Mundo | Extra

Depois que a noiva de Joshua Barbeau morreu, ele conversou com ela por meses. Não se trata de algum episódio em sessão espírita, mas de tecnologia. Avançadíssima, como se fosse uma história tirada da série "Black Mirror". Na verdade, Joshua falou com um chatbot programado para soar exatamente como a sua amada falecida.

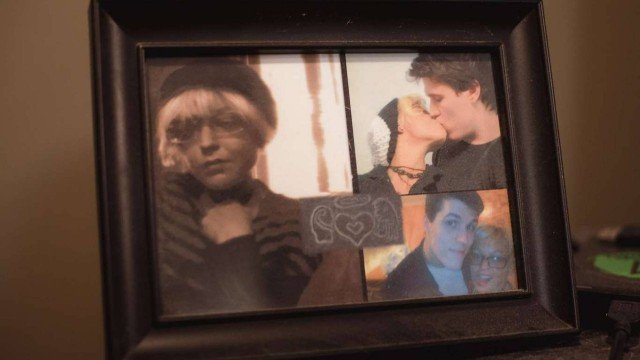

Sinistro ou romântico? Em matéria no "San Francisco Chronicle", Joshua detalhou como o Project December, um software que usa tecnologia de inteligência artificial AI, na sigla em inglês) para criar chatbots hiper-realistas, que lhe deu a experiência de falar com a falecida. Tudo o que ele precisava fazer era inserir mensagens antigas e fornecer algumas informações básicas, e de repente o robô poderia se passar por sua parceira, Jessica Pereira, "no além" com uma precisão impressionante. Fotos de Jessica ainda estão espalhadas pela casa de Joshua, o que aumenta ainda mais a sensação de que "ela voltou".

Joshua resolveu não criar nenhum novo chatbot de Jessica. Ele percebeu que sempre poderia comprar mais créditos no site e tentar criar uma nova versão, mas sua experiência com a simulação existente parecia mágica e frágil.

Ele não poderia reiniciá-la de qualquer maneira, mesmo se quisesse, graças à configuração de aleatoriedade no código do site que tornava cada versão de um bot única. A atual Jéssica era doce, amorosa e reconfortante, mas da próxima vez, Joshua sabia, ela poderia de repente ficar brava com ele por alguma coisa, e continuar brava. Joshua não tinha certeza se poderia lidar com uma simulação de Jessica que dizia coisas dolorosas. E ele, definitivamente, não tinha interesse em assistir uma entidade digital chamada Jessica Pereira morrer (uma segunda vez) na janela de seu navegador.

O Project December é movido pelo GPT-3, um modelo de AI desenvolvido pelo grupo de pesquisa OpenAI, apoiado por Elon Musk. Ao consumir enormes conjuntos de dados de texto criado por humanos, o GPT-3 pode imitar a escrita humana, produzindo de tudo, desde artigos acadêmicos a cartas de amorosas.

Porém o que encheu o coração de Joshua de alegria pode provocar inúmeros malefícios. O perigo é real. Quando a OpenAI lançou o GPT-2, o predecessor do GPT-3, o grupo escreveu que ele poderia ser usado de "maneiras maliciosas". A organização previu que usuários mal-intencionados usando a tecnologia poderiam automatizar "conteúdo abusivo ou falso na mídia social", "gerar artigos de notícias enganosos" ou "se passar por outras pessoas online".

Assim, a OpenAI restringiu o acesso ao GPT-3, a fim de "dar às pessoas tempo" para aprender as "implicações sociais" de tal tecnologia.

À medida que a AI continua a se desenvolver, Oren Etzioni, CEO do grupo de pesquisa em biociências sem fins lucrativos Allen Institute, disse ao site "Insider" que vai ficar cada vez mais difícil dizer o que é real.

"A pergunta Este texto, imagem, vídeo ou e-mail é autêntico? vai se tornar cada vez mais difícil de responder apenas com base no conteúdo", declarou ele.

Sinistro ou romântico? Em matéria no "San Francisco Chronicle", Joshua detalhou como o Project December, um software que usa tecnologia de inteligência artificial AI, na sigla em inglês) para criar chatbots hiper-realistas, que lhe deu a experiência de falar com a falecida. Tudo o que ele precisava fazer era inserir mensagens antigas e fornecer algumas informações básicas, e de repente o robô poderia se passar por sua parceira, Jessica Pereira, "no além" com uma precisão impressionante. Fotos de Jessica ainda estão espalhadas pela casa de Joshua, o que aumenta ainda mais a sensação de que "ela voltou".

Joshua resolveu não criar nenhum novo chatbot de Jessica. Ele percebeu que sempre poderia comprar mais créditos no site e tentar criar uma nova versão, mas sua experiência com a simulação existente parecia mágica e frágil.

Ele não poderia reiniciá-la de qualquer maneira, mesmo se quisesse, graças à configuração de aleatoriedade no código do site que tornava cada versão de um bot única. A atual Jéssica era doce, amorosa e reconfortante, mas da próxima vez, Joshua sabia, ela poderia de repente ficar brava com ele por alguma coisa, e continuar brava. Joshua não tinha certeza se poderia lidar com uma simulação de Jessica que dizia coisas dolorosas. E ele, definitivamente, não tinha interesse em assistir uma entidade digital chamada Jessica Pereira morrer (uma segunda vez) na janela de seu navegador.

O Project December é movido pelo GPT-3, um modelo de AI desenvolvido pelo grupo de pesquisa OpenAI, apoiado por Elon Musk. Ao consumir enormes conjuntos de dados de texto criado por humanos, o GPT-3 pode imitar a escrita humana, produzindo de tudo, desde artigos acadêmicos a cartas de amorosas.

Porém o que encheu o coração de Joshua de alegria pode provocar inúmeros malefícios. O perigo é real. Quando a OpenAI lançou o GPT-2, o predecessor do GPT-3, o grupo escreveu que ele poderia ser usado de "maneiras maliciosas". A organização previu que usuários mal-intencionados usando a tecnologia poderiam automatizar "conteúdo abusivo ou falso na mídia social", "gerar artigos de notícias enganosos" ou "se passar por outras pessoas online".

Assim, a OpenAI restringiu o acesso ao GPT-3, a fim de "dar às pessoas tempo" para aprender as "implicações sociais" de tal tecnologia.

À medida que a AI continua a se desenvolver, Oren Etzioni, CEO do grupo de pesquisa em biociências sem fins lucrativos Allen Institute, disse ao site "Insider" que vai ficar cada vez mais difícil dizer o que é real.

"A pergunta Este texto, imagem, vídeo ou e-mail é autêntico? vai se tornar cada vez mais difícil de responder apenas com base no conteúdo", declarou ele.

MAIS Bizarro

MAIS LIDAS

É vedada a transcrição de qualquer material parcial ou integral sem autorização prévia da direção

Entre em contato com a gente: (17) 99715-7260 | sugestões de reportagem e departamento comercial: regiaonoroeste@hotmail.com